Deep Fakes: Neue Herausforderungen für Unternehmen

Künstliche Intelligenz und Machine Learning gewinnen immer mehr an Bedeutung. Durch „Deep Fakes“ allerdings entstehen den Unternehmen neue Herausforderungen.

Durch Deep Fakes, also die gezielte Manipulation von Video-, Audio- und Bildmaterial, können Unternehmen große finanzielle und gesellschaftliche Schäden entstehen – eine neue Herausforderungen. Dabei gewinnen Künstliche Intelligenz (KI) und Machine Learning immer mehr an Bedeutung, denn diese Technologien erlauben es, Probleme zu lösen, die vorher nicht handhabbar waren – zum Beispiel in der Medizin durch automatisierte Tumorerkennung, in der Kriminalistik durch Betrugsprävention oder auch bei der Übersetzung von Sprachen. Doch KI-Methoden können auch eingesetzt werden, um jemandem zu schaden.

Was wie ein Drehbuch für einen Krimi klingt, ist inzwischen zur realen Bedrohung geworden: Ein Finanzverantwortlicher bekommt den Anruf seines Vorgesetzten, der ihn um die Transaktion von 200.000 Euro auf ein ausländisches Konto bittet. Der Mitarbeitende steht unter Druck, denn die Überweisung muss noch vor Feierabend getätigt werden, sonst drohe eine Vertragsstrafe. Er wundert sich zwar über den Auftrag – normalerweise kommen solche Anweisungen nicht vom Chef direkt – aber da er die Stimme seines Vorgesetzten eindeutig am Telefon erkannt hat, überweist er das Geld. Am nächsten Tag fällt der Vorgesetzt aus allen Wolken: Er hat einen derartigen Auftrag nie gegeben. Es stellt sich heraus, dass Kriminelle seine Stimme kopiert haben und die Firma somit Opfer von Betrug geworden ist.

Dieses Beispiel zeigt: Audiomaterial kann heutzutage täuschend echt gefälscht werden. Das Gleiche gilt für Video- und Bildmaterial. Nicht umsonst setzen inzwischen Polizei und andere staatliche Behörden bei der Beweismittelsicherung Experten zur Erkennung von Deep Fakes ein.

Deep Fakes funktionieren mithilfe neuronaler Netze

Doch wie ist es überhaupt möglich, derartige Fälschungen zu erstellen? Der Begriff „Deep Fake“ ist eine Zusammensetzung aus den englischen Wörtern „fake“ (= Fälschung) und „deep learning“ (deep = tief), einem Verfahren der KI. Die Erstellung von Deep Fakes funktioniert mithilfe neuronaler Netze. Diese bestehen aus mehreren Millionen künstlicher Neuronen und sind in der Lage, die Bewältigung komplizierter Aufgaben zu erlernen. Durch ausreichendes Trainingsmaterial, das für die Zielperson zur Verfügung steht, lernt und versteht das neuronale Netz den Zusammenhang zwischen Buchstaben und Lauten und kann die Stimme der Zielperson kopieren.

Dass die Bedeutung von Deep Fakes steigt, zeigt auch die Fülle an Informationen, die inzwischen zur Erstellung von manipuliertem Material zur Verfügung stehen: Code-Vorgaben, Anleitungen und die entsprechende Software sind im Internet kostenlos verfügbar. Die Rechenkapazität für das Training des Modells kann für einen geringen Betrag bei Cloud-Providern legal gemietet werden. Bereits ein geringes Volumen an Trainingsdaten genügt: Eine halbe Stunde Audiomaterial ist ausreichend, um eine Stimme zu klonen. Dafür eignet sich fast jedes Tonmaterial, zum Beispiel ein Interview, eine Ansprache oder ein Vortrag. Für öffentlich agierende Personen oder Privatpersonen mit frei zugänglichem Video- beziehungsweise Audiomaterial ergibt sich damit eine besondere Gefährdung. Aber auch für Polizei und Justiz, die Versicherungs- und Finanzbranche sowie für Unternehmen können durch Fälschung, Verschleierung und Betrug hohe finanzielle Schäden beziehungsweise Fehlbeurteilungen entstehen.

Herausforderung für Finanzdienstleister und ID-Provider

Aktuell stehen insbesondere Finanzdienstleister und ID-Provider vor der Herausforderung, Deep Fakes zu erkennen. Denn immer mehr Unternehmen erlauben ihren Kunden, sich per Stimme zu identifizieren. Dies ist nutzerfreundlich und spart dem Kunden Zeit und Aufwand. Für Unternehmen bietet der Service eines Identity Providers (ID-Providers) die Vorteile einer schnellen und automatisiert ablaufenden, digitalen Verifizierung von Personen. Solche Lösungen finden Anwendung bei Versicherungsunternehmen, Finanzdienstleistern, in den Bereichen mobile Kommunikation, Mobilität und Telekommunikation, aber auch in öffentlichen Einrichtungen sowie bei Behörden und Justiz.

Deep Fakes sind in der Lage, diese Identifizierungsalgorithmen zu täuschen. Unberechtigte Personen könnten so beispielsweise Zugriff auf Konten der Zielperson erlangen oder wären in der Lage, im Namen der Zielperson (Versicherungs-)Verträge abzuschließen, Kredite aufzunehmen, Bankkonten zu eröffnen oder Gelder zum Zweck der Geldwäsche auf andere Konten zu transferieren. Die Auswirkungen der schadhaften Handlungen richten sich dabei also sowohl gegen einzelne Personen sowie gegen die Gesellschaft als Ganzes.

Deep Fakes stellen also grundlegend in Frage, welchen Medieninhalten wir vertrauen können. Lange galten Audio- und Videomaterial als so komplex, dass sie nicht zu fälschen waren. Dies hat sich nun grundlegend geändert: Nicht das Medienmaterial, also zum Beispiel eine Tonaufnahme als solches, schafft Vertrauen, sondern erst der Kontext, in dem es publiziert wird – genau wie beim geschriebenen Wort oder, seit der Erfindung von Photoshop, wie bei Bildern.

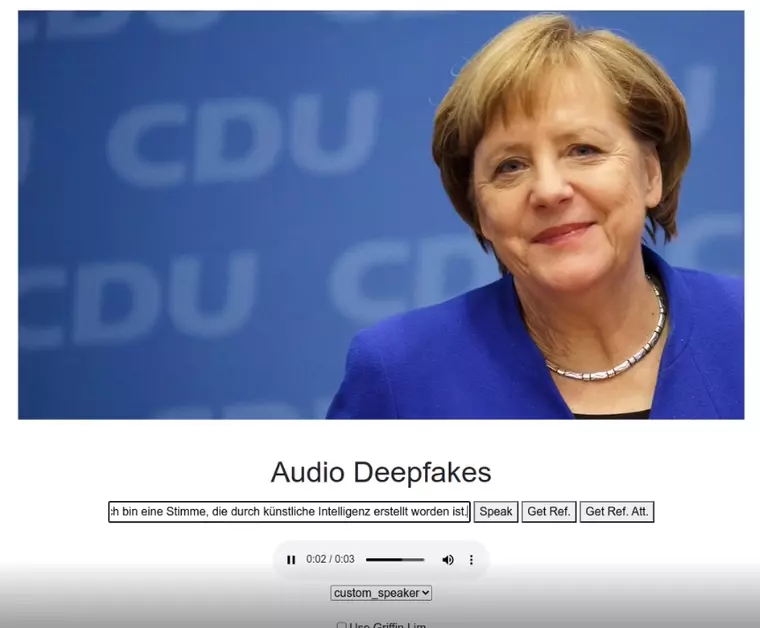

Unternehmen und Forschungsinstitute stehen vor der Herausforderung, auf diese neuen Bedrohungen zur reagieren. Um Betrug durch Social Engineering zu verhindern, muss Medienmaterial künftig stärker hinterfragt werden. Erscheinen Handlungsaufforderungen zweifelhaft, ist es ratsam, mit der natürlichen (Ziel-)Person in Kontakt zu treten und die Anfrage zu verifizieren. Daher bedarf es auch einer Sensibilisierung für die Möglichkeiten von Deep Fakes. Hierzu kann ein Demonstrator dienen, der das Potenzial der Technologie aufzeigt.

„Filter“ gegen Deep Fakes

Aber auch technische Ansätze können dazu beitragen, die Authentizität von Video- und Audiomaterial zu verifizieren. Ähnlich wie zur Erstellung von Deep Fakes können neuronale Netze auch zu ihrer Erkennung angelernt werden. Dies funktioniert, indem dem Netz eine Reihe echter und manipulierter Aufnahmen vorgeführt werden und dieses dadurch lernt, Unstimmigkeiten im Material zu ermitteln. Nach einer automatisierten Prüfung liefert es dem Nutzer nur das, was als „Original“ eingestuft wurde: Ähnlich einem Spam-Filter werden synthetische Inhalte blockiert oder zumindest markiert. Derartige Erkennungssysteme bedürfen einer sehr geringen „False-positive“-Rate (Rate für Falschmeldungen), was aktuell eine Herausforderung für die Realisierung einer entsprechenden Lösung darstellt.

Die Experten am Fraunhofer Aisec erforschen kognitive Sicherheitstechnologien und entwickeln für Unternehmen, Behörden und Finanzinstitute Lösungen zur Erkennung von Video- und Audio-Deep-Fakes.

Passend zu diesem Artikel

Der neue Hauptgeschäftsführer von BDSW und BDGW, Dr. Peter Schwark, ist jetzt seit rund 100 Tagen im Amt. Anlass für PROTECTOR, nach den Herausforderungen für die Sicherheitswirtschaft zu fragen.

KI hält auch in der Sicherheitstechnik verstärkt Einzug. Zusammen mit Deep Learning werden Sicherheitsprozesse in den unterschiedlichsten Bereichen optimiert.

I-Pro kündigt eine neue AI On-site Learning-Kameraserie an, die nicht-KI-basierte Kameras mit KI ausstattet.